Project-MONAI教程:基于5万例3D医学影像的SwinUNETR预训练模型实践指南

Project-MONAI教程:基于5万例3D医学影像的SwinUNETR预训练模型实践指南前言在医学影像分析领域,深度学习模型的性能往往受限于标注数据的稀缺性。Project-MONAI团队最新发布的SwinUNETR预训练模型通过自监督学习技术,在超过5万例3D CT和MR影像上进行预训练,为医学影像分割任务提供了强大的基础模型。本文将深入解析这一技术方案,并指导读者如何在自己的数据集上微..

Project-MONAI教程:基于5万例3D医学影像的SwinUNETR预训练模型实践指南

前言

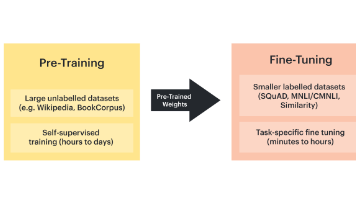

在医学影像分析领域,深度学习模型的性能往往受限于标注数据的稀缺性。Project-MONAI团队最新发布的SwinUNETR预训练模型通过自监督学习技术,在超过5万例3D CT和MR影像上进行预训练,为医学影像分割任务提供了强大的基础模型。本文将深入解析这一技术方案,并指导读者如何在自己的数据集上微调这一先进模型。

技术背景

SwinUNETR架构特点

SwinUNETR是基于Swin Transformer的3D医学影像分割网络,其核心优势在于:

- 层次化特征提取:通过多阶段下采样和上采样过程捕捉不同尺度的特征

- 局部注意力机制:在保持计算效率的同时建模长距离依赖关系

- 移位窗口策略:增强不同窗口间的信息交互能力

自监督预训练的价值

传统监督学习需要大量标注数据,而医学影像标注成本高昂。自监督学习通过设计预测任务(如图像修复、相对位置预测等)从未标注数据中学习通用特征表示,显著降低了对标注数据的依赖。

预训练数据集详解

模型预训练使用了14个公开数据集,涵盖多种模态和部位:

| 数据集类别 | 数据量 | 影像类型 | 解剖部位 | |------------|--------|----------|----------| | 神经影像 | ~9050 | MR/CT | 脑部 | | 胸腔影像 | ~37900 | CT | 胸腔 | | 乳腺影像 | ~12000 | MR | 乳腺 | | 腹部影像 | ~1600 | CT | 腹部 |

这种多样化的数据组合使模型能够学习到普适的医学影像特征表示。

微调实践指南

数据准备

建议使用Beyond the Cranial Vault (BTCV)数据集进行微调,该数据集包含30例3D腹部CT扫描,标注了13个腹部器官。数据应组织为以下结构:

BTCV/

├── imagesTr/ # 训练影像

├── labelsTr/ # 训练标注

├── imagesTs/ # 测试影像

└── labelsTs/ # 测试标注

关键配置参数

在微调脚本中需要特别注意以下参数:

{

"pretrained_path": "预训练模型路径",

"data_root": "BTCV数据根目录",

"json_path": "划分训练/验证集的JSON文件",

"batch_size": 1, # 由于3D数据内存需求大

"learning_rate": 4e-4,

"max_epochs": 30000

}

训练策略

- 渐进式训练:可先用少量数据(如10%)快速验证模型可行性

- 数据增强:MONAI提供了丰富的3D医学影像增强变换

- 混合精度训练:显著减少显存占用并加速训练

性能评估

下表展示了不同数据量下的微调效果对比:

| 训练数据量 | 随机初始化Dice | 预训练模型Dice | 提升幅度 | |------------|---------------|----------------|----------| | 10%(3例) | 58.29 | 60.47 | +2.18 | | 30%(7例) | 71.22 | 72.43 | +1.21 | | 100%(24例) | 82.63 | 82.64 | +0.01 |

从结果可以看出:

- 小数据场景(≤30%)提升显著

- 大数据场景下预训练优势减弱

- 证明了预训练对数据稀缺场景的价值

进阶技巧

- 部分微调策略:可冻结编码器部分层,只微调解码器

- 学习率预热:前1000步采用线性学习率预热

- 模型集成:训练多个不同初始化的模型进行集成预测

常见问题解答

Q: 如何处理非CT模态数据? A: 可考虑进行模态特定的归一化处理,或添加模态识别通道

Q: 显存不足怎么办? A: 尝试:

- 减小输入patch大小

- 使用梯度累积

- 降低batch size

Q: 如何评估模型泛化性? A: 建议在多个独立测试集上评估,并计算不同器官的Dice标准差

结语

本文介绍的SwinUNETR预训练模型为医学影像分析提供了强大的基础模型,特别适合标注数据有限的场景。通过合理的微调策略,研究人员和开发者可以在自己的特定任务上快速获得性能优异的模型。Project-MONAI将持续更新和改进这一技术方案,推动医学影像AI的发展。

注意:实际应用时请确保遵守各数据集的许可协议,临床使用前需进行充分的验证测试。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)