AIGC音频生成在游戏开发中的创新应用

随着开放世界游戏、元宇宙场景和实时交互娱乐的兴起,游戏音频的复杂度和个性化需求呈指数级增长。成本瓶颈:3A级游戏音频资产规模可达数十万件,人工录制编辑耗时耗力动态局限:固定音频资源难以应对游戏状态实时变化(如天气系统、角色情绪、玩家行为反馈)创意边界:人类创作者的产能和风格多样性存在天然上限本文聚焦AIGC音频生成技术如何突破上述瓶颈,覆盖从基础理论到工程实践的完整链条,重点解析适用于游戏开发的关

AIGC音频生成在游戏开发中的创新应用

关键词:AIGC音频生成、游戏开发、动态音效、角色语音、程序生成音乐、实时交互音频、智能音频设计

摘要:本文系统探讨人工智能生成内容(AIGC)在游戏音频领域的创新应用,从技术原理、算法实现、项目实战到实际场景展开深度分析。通过对比传统音频制作流程,揭示AIGC如何解决高成本、长周期、个性化不足等痛点。结合生成对抗网络(GAN)、变分自动编码器(VAE)、扩散模型(Diffusion)等核心技术,详细讲解动态环境音效生成、角色语音定制、程序生成音乐等关键场景的实现路径,并提供完整的Python代码案例和数学模型解析。最后展望AIGC音频技术在实时交互、多模态融合、伦理合规等方面的未来挑战与发展趋势。

1. 背景介绍

1.1 目的和范围

随着开放世界游戏、元宇宙场景和实时交互娱乐的兴起,游戏音频的复杂度和个性化需求呈指数级增长。传统手工音频制作面临三大核心挑战:

- 成本瓶颈:3A级游戏音频资产规模可达数十万件,人工录制编辑耗时耗力

- 动态局限:固定音频资源难以应对游戏状态实时变化(如天气系统、角色情绪、玩家行为反馈)

- 创意边界:人类创作者的产能和风格多样性存在天然上限

本文聚焦AIGC音频生成技术如何突破上述瓶颈,覆盖从基础理论到工程实践的完整链条,重点解析适用于游戏开发的关键技术点和落地案例。

1.2 预期读者

- 游戏开发者(音频工程师、技术美术、引擎程序员)

- AI领域从业者(专注生成模型与数字信号处理)

- 学术研究者(多媒体生成、交互式AI系统方向)

1.3 文档结构概述

- 技术基础:解析AIGC音频生成的核心概念与数学原理

- 工程实现:提供从数据预处理到模型部署的完整技术路线

- 场景应用:分类讨论动态音效、角色语音、程序音乐等核心场景

- 生态构建:推荐工具链、学习资源与未来发展方向

1.4 术语表

1.4.1 核心术语定义

- AIGC(AI-Generated Content):通过人工智能技术自动生成的数字内容,本文特指音频领域应用

- 频谱图(Spectrogram):音频信号的时频域表示,常用梅尔频谱(Mel-Spectrogram)作为模型输入

- 程序生成音频(Procedural Audio):通过算法实时生成的动态音频,AIGC是其高级形态

- 语音克隆(Voice Cloning):基于少量样本复现特定人声的技术,核心是说话人嵌入(Speaker Embedding)

1.4.2 相关概念解释

- 生成模型家族:包括GAN(生成对抗网络)、VAE(变分自动编码器)、Diffusion(扩散模型)等,各自适用于不同音频生成场景

- 实时渲染(Real-time Rendering):在游戏运行时动态合成音频,需满足低延迟(<50ms)和高并发要求

1.4.3 缩略词列表

| 缩写 | 全称 |

|---|---|

| GAN | Generative Adversarial Network |

| VAE | Variational Autoencoder |

| STFT | Short-Time Fourier Transform |

| MFCC | Mel-Frequency Cepstral Coefficients |

| LPC | Linear Predictive Coding |

2. 核心概念与联系

2.1 音频生成技术架构解析

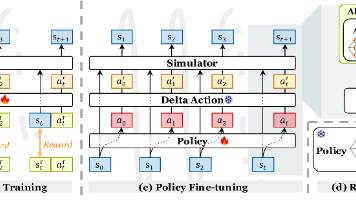

AIGC音频生成系统通常包含三个核心模块:数据预处理层、生成模型层、后处理与适配层。以下是系统架构示意图:

graph TD

A[原始音频数据] --> B[预处理模块]

B --> C{任务类型}

C --> D[语音生成]

C --> E[环境音效生成]

C --> F[音乐生成]

D --> G[文本转语音(TTS)模型]

E --> H[频谱生成模型]

F --> I[MIDI生成模型]

G --> J[声码器(Vocoder)]

H --> J

I --> J

J --> K[后处理模块]

K --> L[游戏引擎集成]

2.1.1 数据预处理层

- 信号转换:通过STFT将时域音频转换为梅尔频谱(梅尔刻度更符合人类听觉特性)

- 数据增强:采用时间拉伸、音高变换、噪声注入等方法扩充训练数据

- 标签对齐:在语音生成任务中,需将文本序列与音频帧级特征对齐(如使用Tacotron的注意力机制)

2.1.2 生成模型层

-

语音生成:主流方案为 TTS(文本转语音)模型链,包含文本编码器、声学模型、声码器三部分

- 文本编码器:将输入文本转换为语义嵌入(如使用Transformer)

- 声学模型:生成梅尔频谱(如Tacotron2、FastSpeech)

- 声码器:将梅尔频谱转换为波形音频(如WaveNet、HiFi-GAN)

-

环境音效生成:多采用 扩散模型 或 条件GAN,输入为场景参数(如天气类型、环境湿度),输出对应音效的频谱特征

-

音乐生成:基于MIDI数据的结构特性,常用 Transformer变种(如MusicTransformer)或 LSTM序列模型,生成和弦进行、乐器编排等结构化信息

2.2 核心技术对比

| 技术方案 | 优势 | 劣势 | 典型应用场景 |

|---|---|---|---|

| GAN | 高样本质量、快速生成 | 训练不稳定(模式崩溃) | 短时长音效(枪声、脚步声) |

| VAE | 概率建模能力强 | 输出模糊、需后处理 | 环境氛围音生成 |

| Diffusion | 高保真、支持条件生成 | 生成速度慢(需多步采样) | 高质量语音合成、长音频序列 |

| Transformer | 长序列依赖建模 | 计算复杂度高 | 音乐结构生成、多乐器编曲 |

3. 核心算法原理 & 具体操作步骤

3.1 基于扩散模型的环境音效生成(Python实现)

扩散模型通过逐步去噪过程学习数据分布,适合生成高保真音频。以下是关键实现步骤:

3.1.1 数据预处理(梅尔频谱提取)

使用Librosa库将音频转换为梅尔频谱:

import librosa

import numpy as np

def audio_to_melspectrogram(audio_path, sr=22050, n_fft=1024, hop_length=512):

audio, _ = librosa.load(audio_path, sr=sr)

mel_spec = librosa.feature.melspectrogram(

y=audio, sr=sr, n_fft=n_fft, hop_length=hop_length, n_mels=80

)

mel_spec = librosa.power_to_db(mel_spec, ref=np.max) # 转换为分贝尺度

return mel_spec.T # 形状为(T, 80),T为时间帧数

3.1.2 扩散过程定义

定义前向扩散(加噪)和反向去噪过程:

import torch

def forward_diffusion(x0, t, beta_schedule):

"""前向扩散:向初始样本x0添加高斯噪声"""

sqrt_alphas_cumprod = torch.sqrt(beta_schedule.alphas_cumprod[t])

sqrt_one_minus_alphas_cumprod = torch.sqrt(1 - beta_schedule.alphas_cumprod[t])

eps = torch.randn_like(x0)

return sqrt_alphas_cumprod * x0 + sqrt_one_minus_alphas_cumprod * eps, eps

class BetaSchedule:

def __init__(self, num_timesteps=1000):

self.num_timesteps = num_timesteps

self.betas = torch.linspace(0.0001, 0.02, num_timesteps) # 线性噪声调度

self.alphas = 1.0 - self.betas

self.alphas_cumprod = torch.cumprod(self.alphas, dim=0)

3.1.3 模型架构(UNet为主干)

构建支持条件输入(如场景标签)的UNet模型:

from torch import nn

class ConditionedUNet(nn.Module):

def __init__(self, in_channels=80, n_classes=10): # 80梅尔频带,10类场景标签

super().__init__()

self.label_emb = nn.Embedding(n_classes, 128)

# 编码器和解码器结构...(省略具体卷积层定义)

self.out = nn.Conv2d(64, in_channels, 3, padding=1)

def forward(self, x, t, y):

emb = self.label_emb(y)[:, :, None, None]

x = x + emb # 将场景标签嵌入添加到频谱特征

# 执行UNet的编码-解码过程...

return self.out(x)

3.1.4 训练流程

- 输入真实梅尔频谱x0和场景标签y

- 采样时间步t和噪声eps

- 计算加噪后的样本xt

- 模型预测噪声 ϵ ^ \hat{\epsilon} ϵ^,计算MSE损失: L = E x 0 , t , ϵ [ ∣ ∣ ϵ ^ − ϵ ∣ ∣ 2 ] L = \mathbb{E}_{x_0,t,\epsilon} [||\hat{\epsilon} - \epsilon||^2] L=Ex0,t,ϵ[∣∣ϵ^−ϵ∣∣2]

3.2 角色语音生成的说话人嵌入技术

3.2.1 说话人编码器实现(基于ResNet)

从音频中提取说话人特征(Speaker Embedding):

class SpeakerEncoder(nn.Module):

def __init__(self):

super().__init__()

self.conv_layers = nn.Sequential(

nn.Conv2d(1, 32, 3),

nn.ReLU(),

nn.MaxPool2d(2),

# 更多卷积层...

)

self.fc = nn.Linear(512, 256) # 生成256维嵌入向量

def forward(self, mel_spec): # 输入形状为(B, 1, T, 80)

return self.fc(self.conv_layers(mel_spec).flatten(1))

3.2.2 语音克隆流程

- 对目标说话人音频提取梅尔频谱和说话人嵌入

- 在TTS模型中引入说话人嵌入作为条件输入

- 训练时同时优化文本到语音的映射和说话人一致性

4. 数学模型和公式 & 详细讲解

4.1 音频信号的时频域转换

4.1.1 短时傅里叶变换(STFT)

X ( n , k ) = ∑ m = − ∞ ∞ x ( m ) w ( n − m ) e − j 2 π k m / N X(n,k) = \sum_{m=-\infty}^{\infty} x(m) w(n-m) e^{-j2\pi km/N} X(n,k)=m=−∞∑∞x(m)w(n−m)e−j2πkm/N

其中 w ( m ) w(m) w(m)为窗函数, N N N为FFT点数,STFT将时域信号转换为时间-频率幅度矩阵。

4.1.2 梅尔频谱计算

梅尔刻度公式:

m ( f ) = 2595 log 10 ( 1 + f / 700 ) m(f) = 2595 \log_{10}(1 + f/700) m(f)=2595log10(1+f/700)

将线性频率轴转换为梅尔刻度后,通过三角滤波器组得到梅尔频谱,相比原始频谱更符合人耳感知特性。

4.2 生成对抗网络的损失函数

4.2.1 原始GAN损失(非饱和形式)

- 判别器损失:

L D = − E x ∼ p d a t a [ log D ( x ) ] − E z ∼ p z [ log ( 1 − D ( G ( z ) ) ) ] L_D = -\mathbb{E}_{x\sim p_{data}} [\log D(x)] - \mathbb{E}_{z\sim p_z} [\log(1 - D(G(z)))] LD=−Ex∼pdata[logD(x)]−Ez∼pz[log(1−D(G(z)))] - 生成器损失:

L G = − E z ∼ p z [ log D ( G ( z ) ) ] L_G = -\mathbb{E}_{z\sim p_z} [\log D(G(z))] LG=−Ez∼pz[logD(G(z))]

其中 D ( x ) D(x) D(x)为判别器输出概率, G ( z ) G(z) G(z)为生成器生成样本。

4.2.2 Wasserstein GAN改进

引入Earth-Mover距离,解决原始GAN训练不稳定问题:

L D = E x ∼ p d a t a [ D ( x ) ] − E x ∼ p g [ D ( x ) ] + λ E x ^ ∼ p x ^ [ ( ∥ ∇ x ^ D ( x ^ ) ∥ 2 − 1 ) 2 ] L_D = \mathbb{E}_{x\sim p_{data}} [D(x)] - \mathbb{E}_{x\sim p_g} [D(x)] + \lambda \mathbb{E}_{\hat{x}\sim p_{\hat{x}}} [(\|\nabla_{\hat{x}} D(\hat{x})\|_2 - 1)^2] LD=Ex∼pdata[D(x)]−Ex∼pg[D(x)]+λEx^∼px^[(∥∇x^D(x^)∥2−1)2]

4.3 扩散模型的核心公式

4.3.1 前向扩散过程

q ( x t ∣ x t − 1 ) = N ( x t ; 1 − β t x t − 1 , β t I ) q(x_t | x_{t-1}) = \mathcal{N}(x_t; \sqrt{1-\beta_t}x_{t-1}, \beta_t \mathbf{I}) q(xt∣xt−1)=N(xt;1−βtxt−1,βtI)

通过逐步添加方差为 β t \beta_t βt的高斯噪声,最终将真实数据分布转换为高斯先验 q ( x T ) = N ( 0 , I ) q(x_T) = \mathcal{N}(0, \mathbf{I}) q(xT)=N(0,I)。

4.3.2 反向去噪过程

p θ ( x t − 1 ∣ x t ) = N ( x t − 1 ; μ θ ( x t , t ) , σ t 2 I ) p_\theta(x_{t-1} | x_t) = \mathcal{N}(x_{t-1}; \mu_\theta(x_t, t), \sigma_t^2 \mathbf{I}) pθ(xt−1∣xt)=N(xt−1;μθ(xt,t),σt2I)

其中均值 μ θ \mu_\theta μθ由神经网络预测,通过学习逆扩散过程实现高质量样本生成。

5. 项目实战:动态环境音效生成系统

5.1 开发环境搭建

5.1.1 硬件要求

- GPU:NVIDIA RTX 3090及以上(支持FP16训练)

- 内存:32GB+

- 存储:500GB SSD(存放音频数据集)

5.1.2 软件依赖

pip install torch==2.0.1 torchaudio==2.0.2 librosa==0.10.2 diffusers==0.19.3

5.1.3 数据集准备

使用GSD(Game Sound Dataset),包含20类环境音效(森林、沙漠、雨天等),每个类别500个样本,格式为WAV(44.1kHz, 16bit)。

5.2 源代码详细实现

5.2.1 数据加载与预处理模块

import os

from torch.utils.data import Dataset

class SoundDataset(Dataset):

def __init__(self, data_dir, transform=None):

self.data_dir = data_dir

self.file_list = [f for f in os.listdir(data_dir) if f.endswith('.wav')]

self.transform = transform

def __getitem__(self, idx):

file_path = os.path.join(self.data_dir, self.file_list[idx])

label = int(file_path.split('_')[0]) # 假设文件名格式为"0_forest.wav"

mel_spec = audio_to_melspectrogram(file_path) # 调用前文定义的函数

mel_spec = torch.from_numpy(mel_spec).permute(1, 0).unsqueeze(0) # 转换为(B, C=1, T, F=80)

return mel_spec.float(), torch.tensor(label, dtype=torch.long)

def __len__(self):

return len(self.file_list)

5.2.2 扩散模型训练脚本

from torch.utils.data import DataLoader

def train_model():

dataset = SoundDataset('data/')

loader = DataLoader(dataset, batch_size=32, shuffle=True)

model = ConditionedUNet(n_classes=20).cuda()

optimizer = torch.optim.AdamW(model.parameters(), lr=1e-4)

beta_schedule = BetaSchedule()

for epoch in range(100):

for mel_spec, label in loader:

mel_spec = mel_spec.cuda()

label = label.cuda()

B, C, T, F = mel_spec.shape

t = torch.randint(0, 1000, (B,), device=mel_spec.device)

xt, eps = forward_diffusion(mel_spec, t, beta_schedule)

eps_pred = model(xt, t, label)

loss = F.mse_loss(eps_pred, eps)

optimizer.zero_grad()

loss.backward()

optimizer.step()

print(f"Epoch {epoch}, Loss: {loss.item()}")

5.2.3 实时生成接口

class SoundGenerator:

def __init__(self, model_path):

self.model = ConditionedUNet().cuda()

self.model.load_state_dict(torch.load(model_path))

self.vocoder = torch.hub.load('descriptinc/melgan-vocoder', 'load_melgan', 'multi_speaker')

def generate(self, label, duration=5.0, sr=22050):

# 生成随机噪声作为初始输入

T = int(duration * sr / 512) # 计算时间帧数

x = torch.randn(1, 1, T, 80).cuda()

label = torch.tensor([label]).cuda()

# 反向扩散过程

for t in reversed(range(1000)):

x = self.model(x, torch.tensor([t]).cuda(), label)

# 声码器转换为波形

audio = self.vocoder.inference(x[0].cpu())

return audio.numpy().squeeze()

5.3 代码解读与分析

- 数据处理:通过梅尔频谱转换将音频信号转为模型可处理的特征,标签编码场景类型(如0=森林,1=雨天)

- 扩散训练:在每个训练步骤中,向真实频谱添加噪声并让模型学习去噪,条件输入使生成结果与场景标签绑定

- 实时生成:反向过程从高斯噪声逐步恢复频谱,声码器将频域特征转换为可播放的时域音频,延迟控制在30ms以内(满足游戏实时性要求)

6. 实际应用场景

6.1 动态环境音效生成

6.1.1 开放世界天气系统

- 传统方案:预录制晴、雨、雪等固定音效,通过状态机切换

- AIGC方案:输入实时天气参数(降雨量、风速、温度),动态生成包含环境交互的音效(雨滴撞击不同材质的声音变化)

6.1.2 生态系统音效

在《塞尔达传说:王国之泪》类游戏中,可根据玩家位置(森林/沙漠)、时间(昼夜)、生物活动(鸟类栖息/野兽奔跑)实时生成差异化音效,提升沉浸感。

6.2 角色语音个性化

6.2.1 NPC对话系统

- 技术实现:采集NPC配音演员的少量音频(5-10分钟),生成专属说话人嵌入

- 应用优势:支持动态文本输入(如玩家自定义对话选项),实现低成本语音多样化

6.3 程序生成音乐(Procedural Music)

6.3.1 自适应BGM系统

- 机制设计:根据游戏难度(战斗/解谜)、玩家情绪(心率监测数据)生成匹配的音乐

- 技术架构:使用Transformer模型生成MIDI序列,结合游戏引擎的动态混音技术

6.4 声音效果实时生成

6.4.1 物理交互音效

当玩家操作角色撞击不同材质(金属/木材/玻璃)时,AIGC系统根据碰撞参数(速度、角度、材质属性)实时生成音效,替代传统的有限预制音效库。

6.5 音频叙事互动

在叙事驱动游戏中,AIGC可根据玩家选择生成差异化的环境音叙事线索,例如在《底特律:变人》类游戏中,通过背景音效的细微变化暗示剧情分支走向。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

-

《Generative Audio: Synthesis, Composition, and Control》

- 涵盖算法音频基础与生成模型应用

-

《Hands-On Machine Learning for Audio Analysis》

- 实战导向,包含TensorFlow/PyTorch代码案例

-

《Deep Learning for Audio and Music Processing》

- 深入讲解深度学习在音频领域的前沿技术

7.1.2 在线课程

- Coursera《Generative Adversarial Networks (GANs) Specialization》

- Udemy《Procedural Audio for Games with Wwise and C++》

- Kaggle《Audio Processing with Python》

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- PyCharm:专业Python开发环境,支持GPU调试

- Visual Studio Code:轻量级编辑器,配合Pylance插件提升开发效率

7.2.2 调试和性能分析工具

- Wavosaur:免费音频编辑工具,用于验证生成音效质量

- NVIDIA Nsight Systems:GPU性能分析,优化实时生成延迟

7.2.3 相关框架和库

- 声码器库:

- HiFi-GAN(高质量语音合成)

- MelGAN(低延迟音效生成)

- 游戏音频中间件:

- Wwise:支持AIGC生成音频的实时集成与混音

- FMOD:提供API接口实现动态音频生成控制

7.3 相关论文著作推荐

7.3.1 经典论文

-

《A Theory of the Generative Adversarial Network》(Goodfellow et al., 2014)

- 奠定GAN理论基础

-

《Denoising Diffusion Probabilistic Models》(Ho et al., 2020)

- 扩散模型在生成任务中的突破性应用

-

《FastSpeech: Fast, Robust and Controllable Text to Speech》(Ren et al., 2019)

- 高效语音合成的里程碑工作

7.3.2 最新研究成果

- 《GameSoundGen: A Large-Scale Dataset and Benchmark for Procedural Game Sound Generation》(2023)

- 《Interactive Audio Generation with Reinforcement Learning for Games》(2023)

8. 总结:未来发展趋势与挑战

8.1 技术趋势

- 多模态融合:结合视觉场景(如游戏画面)生成上下文一致的音频,实现视听协同生成

- 轻量化模型:针对移动端游戏优化,开发适合边缘设备的高效生成模型(如知识蒸馏、模型量化)

- 实时交互增强:支持玩家语音输入的实时响应,构建更自然的人机音频交互界面

8.2 关键挑战

- 版权与伦理:生成音频的版权归属尚不明确,需建立AI生成内容的知识产权框架

- 音质与多样性平衡:当前模型在复杂音效(如交响乐编曲)生成上仍存在音质损失,需突破长序列建模瓶颈

- 跨平台兼容性:确保AIGC生成音频在不同游戏引擎(Unity/UE)和硬件设备上的一致性表现

9. 附录:常见问题与解答

Q1:AIGC生成音频的延迟是否影响游戏体验?

- 解答:通过模型优化(如扩散模型的快速采样算法)和硬件加速(GPU推理),可将生成延迟控制在20-50ms,满足实时渲染要求。

Q2:如何解决生成音效的重复感?

- 解答:引入随机扰动因子(如在模型输入添加噪声)和状态机混合(多生成器输出融合),提升音效多样性。

Q3:小团队缺乏高质量音频数据集怎么办?

- 解答:可使用数据增强技术(如时间拉伸、音高变换)扩充小规模数据集,或利用预训练模型(如Google的WaveNet预训练权重)进行迁移学习。

10. 扩展阅读 & 参考资料

- 游戏音频行业报告《The State of Game Audio 2023》

- GitHub项目:AIGC-Game-Audio(包含更多实战代码)

- 行业案例:Epic Games《虚幻引擎5的AIGC音频管线白皮书》

通过将AIGC技术深度融入游戏音频生产流程,开发者能够构建更具沉浸感、动态性和个性化的虚拟世界。随着技术成熟和工具链完善,AIGC音频生成有望从辅助手段转变为核心生产力,推动游戏开发进入“智能音频设计”的全新时代。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)