大模型三种微调Fine-tuning方式深度分析 2025

*:**

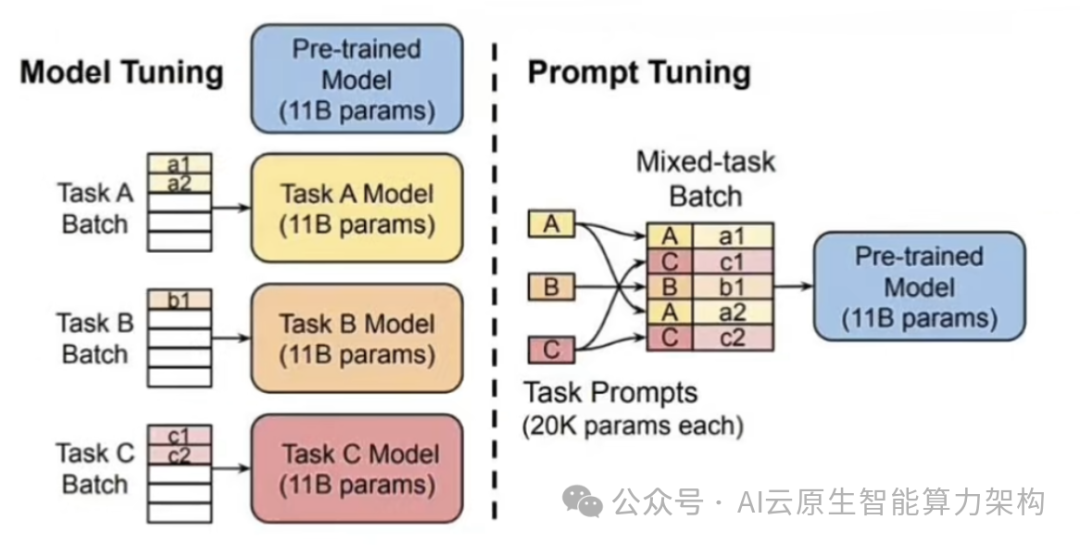

方式一: Prompt-tuning

什么是Prompt-tuning?

Prompt-tuning通过修政输入文本的提示(Prompt)来引导模型生成符合特定任务或情境的输出,而无需对模型的全量参数进行微调。

这种方法利用了预训练语言模型 (PLM)在零样本或少样本学习中的强大能力,通过修改输入提示来激活模型内部的相关知识和能力。

一、Prompt-tuning:激活模型的「隐形指令」

*核心原理*:

通过修改输入文本的提示(Prompt)来引导预训练语言模型(PLM)生成特定任务的输出,而无需微调整个模型参数。其核心逻辑是将任务需求编码为可学习的连续向量(软提示),通过调整这些向量间接激活模型内部已有的知识,而非直接修改模型权重。

*1. 实施步骤*:

设计提示模板**:**

-

模板需包含任务描述(如「判断以下文本的情感倾向:」)、输入占位符(如

{text})和输出格式要求(如「答案:[positive/negative]」)。示例:

prompt_template = "分类任务:{text},请给出类别标签:"

*准备数据集:*

监督学习任务需包含输入文本与真实标签(如情感分类的正负样本);生成任务需定义预期输出格式(如摘要长度、风格)。

*1. 微调提示嵌入:*

在输入层添加可学习的提示向量(通常长度为 10-100 个 token),通过反向传播优化这些向量,最小化任务损失。

*2. 参数效率:*

*仅需微调提示嵌入(如 GPT-3 的提示参数仅占总参数的 0.1%),显著降低计算成本。*

*3. 关键优势*:

**黑盒适配:**适用于无法访问模型内部参数的场景(如 API 调用)。

*低资源友好:**在小样本任务中表现优于传统微调,尤其适合医疗、法律等标注数据稀缺的领域。*

*多任务共享:**不同任务可独立训练提示向量,无需重新训练整个模型。*

*4. 局限性*:

**模板敏感性:**提示的位置、长度或措辞可能显著影响性能(如分类任务中,提示放在句首或句尾效果不同)。

*复杂任务瓶颈:**对跨模态或逻辑推理任务(如数学证明)效果有限,需结合其他方法(如 LoRA)。*

方式二: Prefix-tuning

什么是Prefix-tuning?

Prefix-tuning是Prompt-tuning的一种变体,它通过在输入文本前添加一段可学习的“前缀”来指导模型完成任务。

**这个前缀与输入序列一起作为注意力机制的输入,从而影响模型对输入序列的理解和表示。**由于前缀是可学习的,它可以在微调过程中根据特定任务进行调整,使得模型能够更好地适应新的领域或任务。

二、Prefix-tuning: Transformer 层间的[隐形操控

核心原理:

作为 Prompt-tuning 的进阶版,Prefix-tuning 在Transformer 的每一层注意力模块的键(Key) 和值 (Value矩阵前插入可学习的前缀向量。这些前缀向量与输入序列共同参与注意力计算,从而引导模型关注任务相关特征。

实施步骤

1. 初始化前缀嵌入:

为每个 Transformer 层生成可学习的前缀矩阵(如长度为 20 的向量) ,通常使用任务描述文本通过预训O练模型编码初始化,以提升收敛速度,

2. 拼接输入与前缀:

将前缀向量与原始输入的词嵌入拼接,形成新的输入表示(如[prefix] + [input])训练模型:

3. 训练模型:

冻结基座模型参数,仅优化前缀向量。训练时,前缀向量通过反向传播调整,影响注意力权重分布。

4. 技术突破:

层间干预: 相比 Prompt-tuning 仅在输入层添加提示,Prefix-tuning 在每一层注入前缀,更精细地控制模型决策过程。

长文本适配: 通过调整前缀长度(如 50-100 token),可灵活处理文档级生成任务(如法律合同摘要)

5. 典型应用:

文本生成: 在摘要、翻译任务中,Prefix-tuning 通过隐式指令引导模型生成符合要求的输出,性能接近全量微调但参数量减少99%。

低资源学习: 在仅有 100 个样本的场景中,Prefix-tuning 的泛化能力显著优于传统微调,适用于罕见病诊断等领域。

方式三: LoRA

什么是LoRA?

LoRA (Low-Rank Adaptation)通过分解预训练模型中的部分权重矩阵为低秩矩阵,并仅微调这些低秩矩阵的少量参数来适应新任务。

三、LORA: 矩阵分解的参数瘦身术

核心原理:

通过将预训练模型的权重矩阵分解为低秩矩阵(如w = WO + BA) ,仅微调低矩阵A和B,从而以极小的计算成本实现模型适配。其核心逻辑是利用矩阵的低秩特性,减少可训练参数数量。

实施步骤

插入 LoRA 模块:

通常设置在 Transformer 的每一层注意力或前馈网络中插入可训练的低秩矩阵A(降维)和B(升维),1O秩 (rank) 为 4-64。

示例:

class LoRALayer(nn.Module): def __init__(self, in_features, out_features, rank=4): super().__init__() self.A = nn.Parameter(torch.randn(rank, in_features)) self.B = nn.Parameter(torch.randn(out_features, rank)) def forward(self, x): return self.B @ self.A @ x

2. 训练策略:

冻结基座模型参数,仅训练A和B。学习率通常设为 1e-4,优化器选择 AdamW 或 Lion。0

参数调整:

- 秩(lora rank): 秩越大,模型表达能力越强,但计算成本越高。简单任务可设为4-8,复杂任务o设为 32-64。

- 缩放系数 (lora_alpha): 通常设为的 2 倍(如 rank=8 时 alpha=16),确保训练稳定。

- Dropout (lora_dropout) : 设为 0.1-0.3 以防止过拟合。

3. 技术演进

LORA+: 通过为矩阵A和B设置不同的学习率 (如eta A=1e-3,eta B=5e-4)提升微调速度2 倍,尤其在医疗影像分析等复杂任务中效果显著在消费级显卡 (如 RTX3090) 上实现 70B 模型的高效微调。

*QLoRA:**结合量化技术(如 4-bit 权重),在消费级显卡(如 RTX 3090)上实现 70B 模型的高效微调。*

4. 应用场景:

多模态融合: 在医疗领域,LoRA 可将CT 影像特征与病历文本结合,提升诊断准确率(如胃肠神经内分泌肿瘤检出率从 62% 提升至 88%)

实时推理优化: 训练后的LORA 模块可与基座模型合并,生成轻量化模型(如 7B 模型压缩至1.48),支持移动端部署。

四、三种方法对比与选择建议

*选择策略*:

***资源受限场景:*优先选择 LoRA 或 Prefix-tuning,减少显存占用(如 70B 模型全量微调需 1600GB 显存,而 LoRA 仅需 20GB)。

*2. 任务类型:*

- **分类 / 信息抽取:**Prompt-tuning(快速适配)或 LoRA(提升精度)。

- **文本生成:**Prefix-tuning(层间控制)或 LoRA(多模态融合)。

*3. 数据规模****:*****

-

**小样本(<1000 例):**Prompt-tuning 或 Prefix-tuning。

-

**大样本(>10 万例):**LoRA(充分利用数据)。

五、工具推荐

LLaMA-Factory: 集成 LoRA、QLoRA 等技术,支持可视化训练与推理,兼容主流开源模型(如 LLaMA,Qwen).

Hugging Face PEFT: 提供 Prefix-tuning 和 LORA 的 API接口,支持快速实验

通过灵活选择上述方法,开发者可在保持模型性能的同时,显著降低微调成本,加速大模型在垂直领域的落地

如何学习AI大模型 ?

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。【保证100%免费】🆓

CSDN粉丝独家福利

这份完整版的 AI 大模型学习资料已经上传CSDN,朋友们如果需要可以扫描下方二维码&点击下方CSDN官方认证链接免费领取 【保证100%免费】

读者福利: 👉👉CSDN大礼包:《最新AI大模型学习资源包》免费分享 👈👈

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

👉1.大模型入门学习思维导图👈

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

对于从来没有接触过AI大模型的同学,我们帮你准备了详细的学习成长路线图&学习规划。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。(全套教程文末领取哈)

👉2.AGI大模型配套视频👈

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,每个章节都是当前板块的精华浓缩。

👉3.大模型实际应用报告合集👈

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(全套教程文末领取哈)

👉4.大模型落地应用案例PPT👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。(全套教程文末领取哈)

👉5.大模型经典学习电子书👈

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。(全套教程文末领取哈)

👉6.大模型面试题&答案👈

截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。为了让大家更容易上车大模型算法赛道,我总结了大模型常考的面试题。(全套教程文末领取哈)

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习

CSDN粉丝独家福利

这份完整版的 AI 大模型学习资料已经上传CSDN,朋友们如果需要可以扫描下方二维码&点击下方CSDN官方认证链接免费领取 【保证100%免费】

读者福利: 👉👉CSDN大礼包:《最新AI大模型学习资源包》免费分享 👈👈

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)