大模型算法岗面试题系列(十八)| 如果想要在某个模型基础上做全参数微调,究竟需要多少显存?

全参数微调意味着在预训练模型的基础上,调整所有参数以适应特定的任务或数据集。所需显存量取决于多个因素,包括模型的大小、批量大小、优化算法以及使用的硬件等。这是一个非常大的数字,实际上,我们还需要考虑其他因素,如优化器状态、激活和中间层存储等,这将使实际需求的显存更大。此外,现代GPU通常没有这么多显存,因此可能需要采用减小批量大小、使用模型并行化、分布式训练或混合精度训练等策略来适应硬件限制。

面试题:如果想要在某个模型基础上做全参数微调,究竟需要多少显存?

参考答案

全参数微调意味着在预训练模型的基础上,调整所有参数以适应特定的任务或数据集。所需显存量取决于多个因素,包括模型的大小、批量大小、优化算法以及使用的硬件等。

要估计全参数微调所需的显存,我们需要考虑的细节和计算步骤:

- 模型参数数量:首先确定模型的总参数数量。例如,一个有100亿参数的模型(如100,000,000,000)。

- 数据类型:参数通常以32位浮点数(float32)存储,每个参数需要4字节的存储空间。如果使用16位浮点数(float16或bfloat16),则每个参数只需要2字节。

- 批量大小:确定训练时使用的批量大小。批量大小直接影响每个epoch中每个参数的梯度需要存储的次数。

- 梯度存储:在训练过程中,除了模型参数外,还需要存储梯度信息。通常,梯度也会占用与模型参数相同大小的显存。

- 优化器状态:大多数现代优化器(如Adam)会为每个参数存储额外的状态信息,如动量(momentum)和方差(variance)。这通常需要与模型参数相同或更少的显存。

- 激活和中间层存储:在前向和后向传播过程中,模型的激活和中间层结果也需要存储,这取决于模型架构和批量大小。

- 检查点和备份:在训练过程中,可能需要定期保存模型的状态,包括参数和优化器状态,以便于恢复训练。

- 并行化和分布式训练:如果使用数据并行化,每个GPU只需要存储模型的一部分参数和对应的梯度。模型并行化则可能需要在多个GPU上分布模型的不同部分。

- 混合精度训练:使用混合精度(如float16和float32的组合)可以减少显存使用,但可能需要额外的存储来处理精度转换。

- 显存利用率:不同的GPU和深度学习框架的显存利用率可能不同,这会影响实际可用的显存。

- 预留空间:通常需要预留一部分显存作为缓冲,以避免显存溢出。

基于以上因素,显存需求的计算可以更详细地表示为:

显存需求=(模型参数大小+梯度大小)×(批量大小+优化器状态大小)+激活和中间层存储+检查点和备份+预留空间

如果我们以float32为例,并且不考虑优化器状态、激活和中间层存储、检查点和备份以及预留空间,显存需求的基础计算将是:

显存需求=2×(100,000,000,000×4bytes)×批量大小

如果批量大小为32,则:

显存需求=2×(400,000,000,000bytes)×32

显存需求=25,600,000,000,000bytes

显存需求=25,600GB

这是一个非常大的数字,实际上,我们还需要考虑其他因素,如优化器状态、激活和中间层存储等,这将使实际需求的显存更大。此外,现代GPU通常没有这么多显存,因此可能需要采用减小批量大小、使用模型并行化、分布式训练或混合精度训练等策略来适应硬件限制。

文末

有需要全套的AI大模型面试题及答案解析资料的小伙伴,可以微信扫描下方CSDN官方认证二维码,免费领取【

保证100%免费】

更多资料分享

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频,免费分享!

一、大模型全套的学习路线

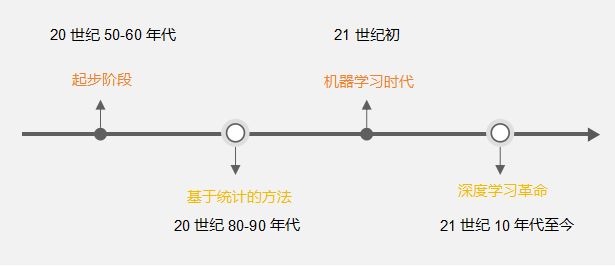

L1级别:AI大模型时代的华丽登场

L2级别:AI大模型API应用开发工程

L3级别:大模型应用架构进阶实践

L4级别:大模型微调与私有化部署

达到L4级别也就意味着你具备了在大多数技术岗位上胜任的能力,想要达到顶尖水平,可能还需要更多的专业技能和实战经验。

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、大模型经典PDF书籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

有需要全套的AI大模型学习资源的小伙伴,可以微信扫描下方CSDN官方认证二维码,免费领取【保证100%免费】

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)