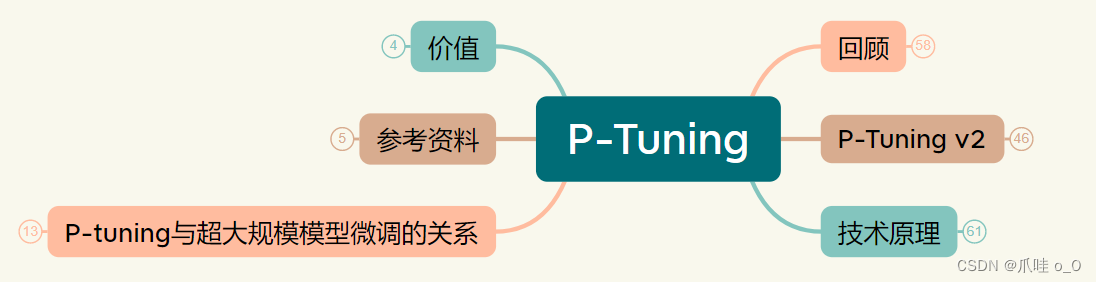

大模型微调技术——P-Tuning及P-Tuning v2总结

从五大模块总结P-Tuning及P-Tuning v2 微调技术,近200个小知识点。【技术回顾】、【P-Tuning技术原理】、【P-Tuning与超大规模模型微调关系】、【P-Tuning价值】、【P-Tuning v2】大模型微调技术系列原理:[大模型微调技术——概述](https://blog.csdn.net/qq_41838627/article/details/132327479)[

·

从五大模块总结P-Tuning及P-Tuning v2 微调技术,近200个小知识点。

【技术回顾】、【P-Tuning技术原理】、【P-Tuning与超大规模模型微调关系】、【P-Tuning价值】、【P-Tuning v2】

可以先去加点油再上车(更好理解4项技术区别和联系!):

大模型微调技术系列原理:

大模型微调技术——概述

大模型微调技术——LoRA

大模型微调技术——Prefix Tuning 与 Prompt Tuning总结

大模型微调技术——P-Tuning及P-Tuning v2总结

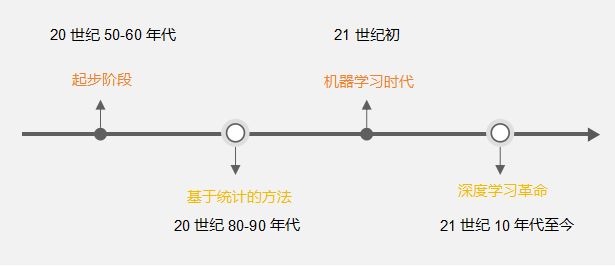

背景回顾

- NLP两大任务:NLU,NLG

- 关于GPT3系列的思考

– 知识与常识能力

– (小样本)自然语言理解 - 预训练模型与知识

– 离散/连续模板 ----》P-Tuning核心思想

表现不佳:第二个问题:是否仅仅是因为基于嵌入 的分类方法 并不适合GPT?

P-Tuning技术原理

- 关于“模板”的理解

- 关键技术

- 细节:增强相关性、Adapter的角度来理解P-tuning

- 和其他微调技术的联系:与Prefix-Tuning的区别 、与Prompt-Tuning的区别

“模板”的理解

关键技术 与 具体细节

和其他微调技术的联系

P-Tuning与超大规模模型微调关系 及 P-Tuning价值

P-Tuning v2

- 提出的背景与目标

- 关键技术

- 小结

参考资料:

https://zhuanlan.zhihu.com/p/391992466

https://zhuanlan.zhihu.com/p/364141928

https://zhuanlan.zhihu.com/p/423902902

https://zhuanlan.zhihu.com/p/635848732

https://zhuanlan.zhihu.com/p/642119029

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)