全栈大模型微调框架LLaMA Factory:从预训练到RLHF的高效实现

主题全栈大模型微调框架LLaMA Factory:从预训练到RLHF的高效实现个人简介郑耀威,北京航空航天大学博士生。以第一作者在CVPR、AAAI、WWW等国际会议发表多篇论文,担任AAAI、EMNLP、Neural Computation等会议和期刊审稿人。获得华为杯、蓝桥杯全国一等奖、北航大学生年度人物、北航博士生奖学金。大模型微调框架LLaMA Factory发起人和主要开发者,GitHu

主题

全栈大模型微调框架LLaMA Factory:从预训练到RLHF的高效实现

个人简介

郑耀威,北京航空航天大学博士生。以第一作者在CVPR、AAAI、WWW等国际会议发表多篇论文,担任AAAI、EMNLP、Neural Computation等会议和期刊审稿人。获得华为杯、蓝桥杯全国一等奖、北航大学生年度人物、北航博士生奖学金。大模型微调框架LLaMA Factory发起人和主要开发者,GitHub开源项目获得超过1万Stars。

郑耀威,北京航空航天大学博士生。以第一作者在CVPR、AAAI、WWW等国际会议发表多篇论文,担任AAAI、EMNLP、Neural Computation等会议和期刊审稿人。获得华为杯、蓝桥杯全国一等奖、北航大学生年度人物、北航博士生奖学金。大模型微调框架LLaMA Factory发起人和主要开发者,GitHub开源项目获得超过1万Stars。

项目地址:https://github.com/hiyouga/LLaMA-Factory

内容概要

LLaMA Factory是一个高效、易用、可扩展的开源全栈大模型微调框架,半年内在GitHub开源社区获得10000关注,并得到Hugging Face、Avalon Labs、美团等多家国内外企业的关注或落地应用。本次分享将从大模型高效训练的角度详细剖析LLaMA Factory的构建动机与组成模块,包括上百种大模型的全栈微调适配原理,LoRA算子优化加速方法,多种微调Trick集成思路等等。

引言部分

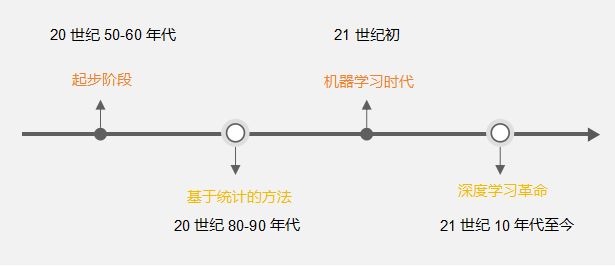

LLaMA、Mistral、Qwen、ChatGLM等国内外大模型在开源后得到了众多关注,然而如何将大模型适配到各自的任务上,则依赖于对大模型的进一步微调。LLaMA Factory作为一个通用、高效的大模型微调框架,能在消费级的硬件资源上对上百种大模型完成调优,并使用不同形态的数据集解锁大模型的通用理解、多轮对话、工具调用等能力。LLaMA Factory通过简单高效的实现,使我们能够在短时间内开展多样化的科学研究和工程应用。

时间

2024.3.9 10:30-11:30

本周六上午不见不散~

视频号直播预约~

进群

为了方便讨论,建立了一个作者交流群,探讨更多细节~

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)